In diesem Artikel beleuchten wir die Herausforderungen und Lösungen im Umgang mit Duplicate Content. Der Leser erfährt, wie Duplicate Content die Sichtbarkeit einer Website beeinträchtigt und erhält praktische Tipps zur Identifizierung und Bereinigung von doppelten Inhalten. Von der Definition über die Vermeidung bis hin zur Erkennung von Duplikaten mit Hilfe von Tools wie Screaming Frog.

Definition von Duplicate Content

Duplicate Content ist definiert als das Vorhandensein identischer oder sehr ähnlicher Inhalte auf mehreren Webseiten oder unter verschiedenen URLs auf derselben Webseite. Für den Nutzer ist es wichtig zu verstehen, dass duplizierte Inhalte die Online-Präsenz einer Website negativ beeinflussen können, indem sie die Auffindbarkeit und das Ranking in Suchmaschinen verringern.

Interner Duplicate Content entsteht häufig durch URL-Parameter, die den gleichen Inhalt unter verschiedenen Adressen zugänglich machen, während externer Duplicate Content durch die Duplizierung von Inhalten auf verschiedenen Webseiten entsteht, was beispielsweise bei mehrsprachigen Angeboten im gleichen Suchmarkt der Fall sein kann.

Tipps um doppelte Inhalte zu vermeiden

Um Duplikate zu vermeiden, sollten die Nutzer verschiedene bewährte Verfahren anwenden, die sowohl interne als auch externe Duplikate adressieren.

1. Externe Duplikate einzigartig machen

Zunächst ist es wichtig, externe Inhalte zu individualisieren. Das bedeutet, dass für jeden Portaleintrag oder ähnliche Inhalte einzigartige Texte erstellt werden sollten, ohne Kopien von der eigenen Website zu verwenden. Sollte eine Überarbeitung der externen Duplikate nicht möglich sein, kann alternativ der Inhalt auf der eigenen Website einzigartig gemacht werden.

2. Bereinigung interner Duplikate

Interne Duplikate sollten identifiziert und bis auf das Original offline gestellt werden. Wichtig ist, dass die offline genommenen Seiten mittels 301-Weiterleitung auf das Original umgeleitet werden, um 404-Fehlerseiten zu vermeiden und die interne Verlinkung anzupassen.

3. Canonical Tags verwenden

Canonical Tags im <head>-Bereich einer Seite weisen Suchmaschinen auf das Original hin. Durch das Setzen von Canonical Links auf alle Duplikate wird die Linkstärke, wenn auch abgeschwächt, auf das Original übertragen.

4. Meta Robots und Noindex

Die Verwendung des Meta-Tags robots mit einem Noindex-Befehl auf Duplikaten sorgt dafür, dass diese Seiten beim nächsten Crawling aus dem Index entfernt werden, ohne dass die Linkstärke übertragen wird.

5. Robots.txt zum Blockieren von Duplikaten

Durch Anweisungen in der robots.txt können bestimmte URLs für Suchmaschinen gesperrt werden. Um Inhalte vollständig zu entfernen, ist jedoch eine manuelle Entfernung über die Google Search Console oder die Bing Webmastertools erforderlich.

6. Domain-Umleitung über .htaccess

Eine Umleitung von non-www- auf www-Domains oder umgekehrt mittels ModRewrite in der .htaccess-Datei verhindert Duplicate Content durch unterschiedliche Domainformen.

7. 301 Redirect für permanente Weiterleitungen

Um alte URLs auf neue Inhalte umzuleiten, sollte ein 301 Redirect verwendet werden, um den PageRank zu erhalten.

8. Header-Funktion in PHP für Weiterleitungen

Alternativ zu .htaccess kann ein Redirect auch direkt in PHP-Dateien mit der header()-Funktion implementiert werden.

9. Verwendung von kanonischen Tags

Canonical Tags im <head>-Bereich helfen, ähnliche Inhalte zu bündeln, indem Suchmaschinen die bevorzugte URL anzeigen.

10. Noindex in META-Tags

Ein noindex in den META Tags signalisiert Suchmaschinen, dass eine Seite nicht indexiert werden soll.

11. Kreativität und Einzigartigkeit

Es ist wichtig, Inhalte selbst zu erstellen und nicht zu kopieren oder zu duplizieren. Unvollständige Seiten sollten mit einem noindex-Tag versehen werden.

12. URL-Parameter in der Google Search Console konfigurieren

Die Google Search Console bietet Werkzeuge zur Konfiguration von URL-Parametern, um Duplicate Content zu vermeiden.

13. Sprachversionen richtig definieren

Das Attribut rel=“alternate“ hreflang=“x“ hilft, verschiedene Sprachversionen einer Website für Suchmaschinen korrekt zu definieren.

Wie finde ich Duplicate Content auf meiner Webseite?

Um Duplicate Content auf einer Website zu finden, können Webmaster den SISTRIX Optimizer verwenden, ein OnPage-Analyse-Tool, das automatisch Duplicate Content identifiziert und detaillierte Informationen zu jeder betroffenen URL liefert. Dieses Tool ist für die OnPage-Optimierung unerlässlich, da es SEO-Fehler aufdeckt und Lösungen vorschlägt.

Google, das Originalität bei der Indexierung bevorzugt, bietet mit der Google Search Console ein weiteres Tool an, das Webmaster bei der Identifizierung von Duplicate Content unterstützt, indem es die Suche nach einzigartigen Textpassagen erleichtert. Darüber hinaus können spezialisierte Tools wie Siteliner, Screaming Frog und Sitebulb eingesetzt werden, um auch subtilere Textduplikate aufzuspüren, die vielleicht nicht direkt das Ranking beeinflussen, aber dennoch wichtig für die Gesamtqualität der Website sind.

Diese Tools scannen den Inhalt und vergleichen Textpassagen, um Übereinstimmungen zu identifizieren, was für die Aufrechterhaltung der Glaubwürdigkeit und des Rankings einer Website in Suchmaschinen unerlässlich ist.

Guide: Doppelte Inhalte finden mit Screaming Frog

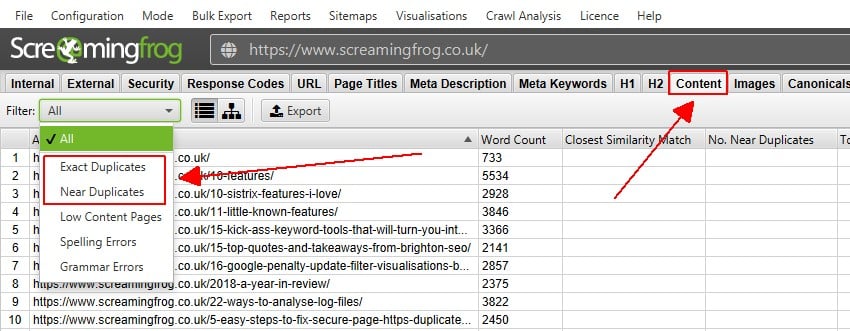

Um Duplicate Content mit Screaming Frog zu finden, muss der Benutzer zunächst die Funktion ‚Near Duplicate‘ konfigurieren, die unter Config > Content > Duplicates zu finden ist. Standardmäßig erkennt der Screaming Frog SEO Spider exakte Duplikate, aber für nahezu identische Inhalte muss die Ähnlichkeitsschwelle, die standardmäßig auf 90% eingestellt ist, nach den Präferenzen des Benutzers angepasst werden.

Es ist auch möglich, nicht indexierbare Seiten in die Prüfung einzubeziehen oder auszuschließen. Nach Abschluss des Crawls werden die Ergebnisse in der Registerkarte Inhalt angezeigt, wo zwei Filter – für exakte und für nahezu identische Duplikate – zur Verfügung stehen.

Nahezu identische Duplikate erfordern eine Analyse des Crawls, um angezeigt zu werden. Seiten, die als nahezu identische Duplikate identifiziert wurden, sollten manuell überprüft werden, da es legitime Gründe für ähnliche Inhalte geben kann, z. B. unterschiedliche Produktkonfigurationen.

Es sollte bewertet werden, ob solche Seiten als separate Einheiten beibehalten werden sollten, ob sie einen einzigartigen Wert für den Nutzer bieten oder ob sie entfernt, zusammengelegt oder verbessert werden sollten. Interessanterweise kann die Ähnlichkeitsschwelle auch nach einem Crawl angepasst und die Crawl-Analyse erneut durchgeführt werden, um mehr oder weniger ähnliche Seiten zu finden, ohne dass der Crawl komplett neu gestartet werden muss.

Für eine detaillierte Anleitung zur Prüfung auf Duplicate Content verweist Screaming Frog auf den SEO Spider User Guide.

Was kann ich bei externen Duplikaten tun?

Bei externen Duplikaten hat der Urheber mehrere Handlungsoptionen. Die erste davon ist nichts zu tun. Dies ist jedoch nur ratsam, wenn die kopierende Seite deutlich weniger Autorität besitzt und von Google bereits als Duplikat identifiziert wurde. In diesem Fall kann immer noch eine Meldung an Google erfolgen, um das Ranking der kopierenden Seite zu beeinflussen.

Eine proaktivere Maßnahme besteht darin, den Website-Betreiber per E-Mail auf die Urheberrechtsverletzung aufmerksam zu machen und ihn aufzufordern, den kopierten Inhalt zu entfernen. Oft reagieren Website-Betreiber positiv auf solche Anfragen, wenn sie höflich formuliert sind und keine böse Absicht hinter der Vervielfältigung steckt. Bleibt diese Kontaktaufnahme erfolglos, bleibt als letzter Ausweg die Einschaltung eines Rechtsbeistandes. Ein Anwalt kann über das weitere Vorgehen informieren und dabei helfen, gegen die unerlaubte Nutzung der eigenen Inhalte vorzugehen.