Doppelter Inhalt beeinträchtigt die Sichtbarkeit und Suchmaschinenoptimierung einer Website erheblich. In den folgenden Abschnitten sprechen wir darüber, was doppelter Inhalt ist, wie er sich auf die SEO-Performance auswirkt, wie man eine Website auf Duplicate Content überprüfen kann und wie Google zu doppelten Inhalten steht.

Des Weiteren wird im Artikel auf die Unterscheidung zwischen internem und externem Duplicate Content eingegangen, die Auswirkungen auf das Google-Ranking diskutiert und Best Practices für den Umgang mit kopierten Inhalten vorgestellt. Abschließend wird auf die Entstehung und die häufigsten Ursachen von doppeltem Content eingegangen.

Was bedeutet Duplicate Content?

Duplicate Content bezeichnet das Phänomen, dass identische oder sehr ähnliche Inhalte auf mehreren Webseiten oder unter verschiedenen URLs auf einer Webseite erscheinen. Für den Nutzer ist es wichtig zu verstehen, dass solche doppelten Inhalte die Auffindbarkeit und das Ranking einer Website in Suchmaschinen beeinträchtigen können.

Interner Duplicate Content entsteht, wenn der gleiche Inhalt auf einer Webseite unter verschiedenen URLs erreichbar ist, was häufig durch URL-Parameter wie Filteroptionen verursacht wird. Externer Duplicate Content tritt auf, wenn Inhalte auf verschiedenen Webseiten dupliziert werden, was beispielsweise bei mehrsprachigen Webseiten im gleichen Suchmarkt der Fall sein kann.

Suchmaschinen wie Google streben eine hohe User Experience an und bevorzugen einzigartige Inhalte, weshalb sie Duplicate Content eher ignorieren oder die betroffenen Seiten im Ranking herabstufen. Daher ist es wichtig, Duplicate Content zu identifizieren und zu entfernen, um die Sichtbarkeit und Glaubwürdigkeit einer Website zu erhalten.

Die Vermeidung von Duplicate Content ist ein zentraler Aspekt der Suchmaschinenoptimierung (SEO), um sicherzustellen, dass Inhalte korrekt indiziert und bewertet werden.

Wie wirkt sich duplizierter Inhalt auf die SEO Performance aus?

Duplicate Content kann sich negativ auf die SEO-Performance einer Website auswirken, da er die Eindeutigkeit und Relevanz der Inhalte für Suchmaschinen wie Google verringert. Duplicate Content führt dazu, dass Suchmaschinen Schwierigkeiten haben, die ursprüngliche Quelle eines Inhalts zu identifizieren, was zu Schwankungen in den SERPs (Search Engine Result Pages) führen kann.

Doppelte Inhalte erschweren es Google, das beste Suchergebnis für Nutzeranfragen zu ermitteln und kann dazu führen, dass die betroffenen Seiten im Ranking abwechselnd auf- und absteigen. Webmaster sollten daher Duplicate Content vermeiden, um eine stabile und verlässliche Sichtbarkeit in den Suchergebnissen zu gewährleisten.

Darüber hinaus kann vorsätzlicher Textdiebstahl oder das bewusste Duplizieren von Inhalten rechtliche Konsequenzen nach sich ziehen und birgt das Risiko, dass sowohl die kopierende als auch die ursprüngliche Seite von Suchmaschinen aus dem Index entfernt werden.

Für eine optimale SEO-Performance ist es daher unerlässlich, einzigartige und wertvolle Inhalte zu erstellen, die den Nutzern einen Mehrwert bieten und den Richtlinien der Suchmaschinen entsprechen.

Wie überprüfe ich meine Webseite auf Duplicate Content?

Der SISTRIX Optimizer ist ein leistungsstarkes Tool zur OnPage-Analyse von Websites, das SEO-Fehler aufdeckt und konkrete Lösungsvorschläge liefert. Er identifiziert automatisch doppelten Content und liefert detaillierte Informationen zu jeder betroffenen URL. So können Webmaster SEO-relevante Fehler erkennen und beheben, was für die OnPage-Optimierung unerlässlich ist.

Google selbst hat ein starkes Interesse an der Indizierung vielfältiger und einzigartiger Inhalte. Die Verwendung von Duplicate Content mit der Absicht, das Ranking zu manipulieren oder Nutzer zu täuschen, kann zu einer Herabstufung oder sogar zur Entfernung der Website aus dem Google-Index führen.

Die Google Search Console bietet Hilfestellung bei der Identifizierung von Duplicate Content und empfiehlt die Suche nach einzigartigen Textpassagen, um Mehrfachlistungen aufzudecken.

Neben der manuellen Suche gibt es auch spezialisierte Tools wie Siteliner, Screaming Frog oder Sitebulb, die beim Aufspüren von Duplicate Content helfen. Diese Tools sind in der Lage, auch kleinere Textduplikate aufzuspüren, die sich zwar nicht direkt auf das Ranking auswirken, aber dennoch Aufmerksamkeit erfordern.

Googles Meinung zu kopierten Inhalten

Google positioniert sich klar gegen kopierte Inhalte, insbesondere wenn diese mit der Absicht eingesetzt werden, das Suchmaschinenranking zu manipulieren oder Nutzer zu täuschen. Die Suchmaschine priorisiert die Indizierung und Anzeige von Seiten mit einzigartigen Informationen und nimmt Korrekturen im Index und im Ranking vor, wenn Duplicate Content entdeckt wird.

Dies kann dazu führen, dass die betroffenen Websites in den Suchergebnissen herabgestuft oder aus dem Google-Index entfernt werden. Google geht nicht automatisch gegen jeden identischen Text vor, ist sich aber der Notwendigkeit bewusst, Ressourcen effizient zu nutzen und die Kosten für das Crawlen und Indizieren von Inhalten zu minimieren.

Angesichts der enormen Menge an Content, die täglich veröffentlicht wird, wie z.B. die Millionen von Blog-Posts auf WordPress, ist die Unterscheidung zwischen Original- und Duplicate Content eine Herausforderung für den Googlebot. Interner Duplicate Content kann auch zu Keyword-Kannibalisierung führen, wenn mehrere Seiten einer Domain um das gleiche Keyword konkurrieren.

Google ist bestrebt, seinen Index schlank und wertvoll zu halten und vermeidet es, Zeit mit der Indizierung redundanter Informationen zu verschwenden.

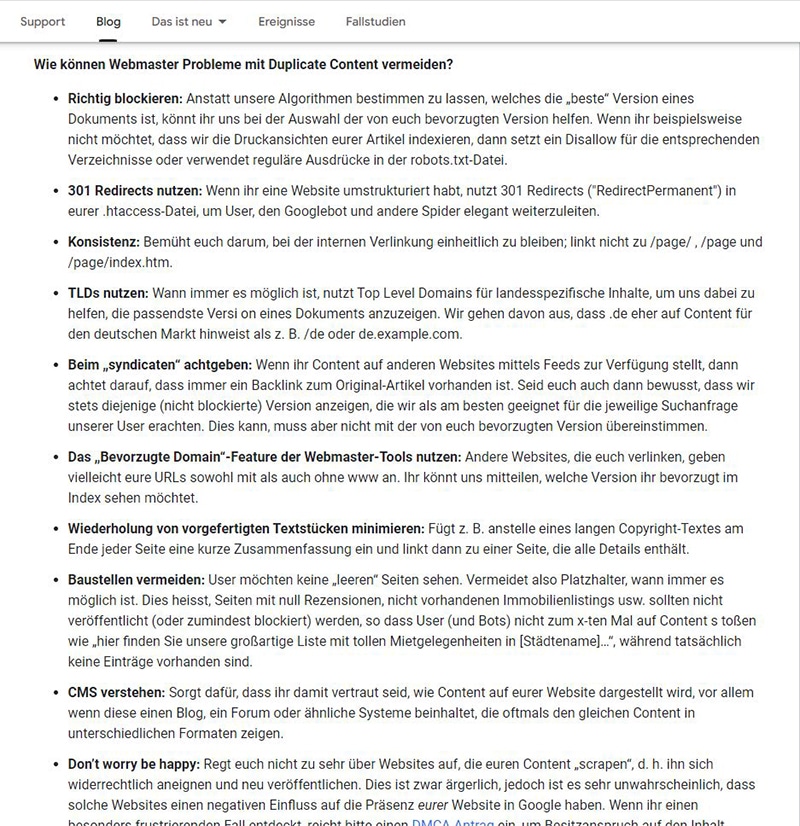

Quelle: https://developers.google.com/search/blog/2006/12/deftly-dealing-with-duplicate-content?hl=de

Interner Duplicate Content

Interner Duplicate Content entsteht, wenn identische oder sehr ähnliche Inhalte innerhalb einer Domain mehrfach vorkommen, was die SEO-Performance beeinträchtigen kann. Besonders anfällig für Duplicate Content sind Online-Shops und redaktionelle CMS, die durch verschiedene Seitentypen wie Tag-Seiten, Filterseiten, Kategorieseiten und paginierte Ansichten entstehen können.

Auch mobile Versionen von Webseiten und druckerfreundliche Seiten können zu Duplicate Content führen. Wiederkehrende Textblöcke in Sidebar und Footer, so genannter Boilerplate Content, sollten auf das Wesentliche beschränkt werden, um die Relevanz der Seite nicht zu schmälern.

Bei internationalen Angeboten ist die korrekte Verwendung des „hreflang“-Attributs entscheidend, um Inhalte für verschiedene Sprachregionen zu kennzeichnen und Duplicate Content zu vermeiden. WordPress-Nutzer sollten darauf achten, auf der Startseite und in den Beiträgen keine identischen Inhalte zu verwenden und stattdessen mit Teasern zu arbeiten. Bei einem Relaunch ist es zudem wichtig, die Testdomain mit einer „.htaccess“-Passwortsicherung vor dem Zugriff durch den Googlebot zu schützen, um nicht ungewollt Duplicate Content zu erzeugen.

Externer Duplicate Content

Externer Duplicate Content bezieht sich auf identische Inhalte, die über verschiedene Domains verteilt sind und kann schwerwiegendere SEO-Probleme verursachen als interner Duplicate Content. Dieses Phänomen tritt nicht nur durch Content-Diebstahl oder Content-Scraping auf, sondern kann auch unbeabsichtigt durch die Verwendung des gleichen Inhalts auf mehreren Webseiten entstehen.

Beispielsweise kann das Kopieren von Artikelbeschreibungen direkt vom Hersteller oder die Verbreitung von Inhalten über RSS-Feeds und Pressemitteilungen zu externem Duplicate Content führen. Für Webseiten mit geringer Domain-Autorität ist es besonders wichtig, neue Inhalte sofort über die Funktion „Crawlen wie von Google“ indexieren zu lassen, um die Priorität in den Suchergebnissen zu sichern.

Zudem kann eine Website, die unter mehreren Domainnamen erreichbar ist, bei Suchmaschinen zu Verwirrung und Rankingproblemen führen, da Google die Relevanz der Inhalte nicht eindeutig zuordnen kann. Um die SEO-Performance zu optimieren, sollten Webmaster darauf achten, einzigartige Inhalte zu erstellen und Mehrfachveröffentlichungen unter verschiedenen Domains zu vermeiden.

Link Equity und doppelte Inhalte auf externen Webseiten

Link Equity, auch bekannt als Link Juice, ist ein zentraler Faktor im Bereich der Suchmaschinenoptimierung und bezieht sich auf die Qualität und Quantität der Backlinks, die auf eine Website verweisen. Diese „Linkkraft“ (oft auch PageRank genannt) ist ein Indikator für die Popularität und Relevanz einer Seite und spielt eine wichtige Rolle für das Ranking einer Seite in den Suchergebnissen (SERPs).

Jeder Link, der auf eine Webseite verweist, wird als Empfehlung gewertet, wobei Links von qualitativ hochwertigen und thematisch relevanten Seiten als besonders stark eingestuft werden. Doppelter Inhalt kann jedoch die Wirksamkeit von Link Equity beeinträchtigen, da der Wert der Backlinks auf mehrere ähnliche Inhalte verteilt wird, was die Autorität und Sichtbarkeit der Hauptseite schwächen kann. Um Link Equity optimal zu nutzen, sollten kopierte Inhalte vermieden und Backlinks auf die ursprüngliche, relevante Seite gelenkt werden, um deren Autorität und Suchmaschinenranking zu stärken.

Verlust von Rankings in Google

Rankingverluste bei Google können durch Schwankungen in den SERPs (Search Engine Results Pages) verursacht werden, die häufig auf Duplicate Content zurückzuführen sind. Duplicate Content erschwert es Google, die relevanteste Seite für eine Suchanfrage zu bestimmen, was zu instabilen Positionen der Ziel-URLs in den Suchergebnissen führen kann.

Um Rankings zu erhalten und zu verbessern, ist es wichtig, einzigartige und qualitativ hochwertige Inhalte anzubieten, die den Suchintentionen der Nutzer entsprechen. Webmaster sollten ihre Inhalte regelmäßig überprüfen und sicherstellen, dass es keine Duplikate innerhalb ihrer Domain oder zwischen verschiedenen Domains gibt.

Eine klare und einzigartige Content-Strategie und die Vermeidung von Content Duplication sind entscheidend, um die Sichtbarkeit in den SERPs zu maximieren und langfristig eine stabile Rankingposition zu sichern.

So sollte man mit doppelten Inhalten umgehen

Duplicate Content kann die Sichtbarkeit einer Website in Suchmaschinen beeinträchtigen. Um dies zu vermeiden, gibt es bewährte Methoden, die dabei helfen, doppelte Inhalte zu vermeiden oder korrekt zu kennzeichnen.

Umleitung via .htaccess

Um Duplicate Content zu vermeiden, kann in der .htaccess-Datei eine Domain-Weiterleitung eingerichtet werden. Dadurch werden Besucher und Suchmaschinen je nach Konfiguration von einer Domain ohne www auf eine Domain mit www oder umgekehrt umgeleitet.

301-Redirect für alte URLs

Für alte, nicht mehr existierende Domains oder Dateien ist ein 301-Redirect sinnvoll. Diese serverseitige Weiterleitung überträgt sowohl den Benutzer als auch die Linkstärke auf das neue Ziel und wird direkt in der .htaccess-Datei des Root-Verzeichnisses vorgenommen.

Einsatz von noindex in META-Tags

Durch das Setzen eines noindex-Vermerks in den META-Tags bestimmter URLs kann verhindert werden, dass diese von Suchmaschinen indexiert und als Duplicate Content gewertet werden.

Verwendung von Canonical Tags

Canonical Tags helfen dabei, Google mitzuteilen, welche Version eines Inhalts relevant ist, wenn mehrere Versionen existieren. Dies wird durch das Hinzufügen eines speziellen Link-Elements im Kopfbereich der Seite erreicht.

Vermeidung von doppelten Content

Es ist wichtig, die Wiederverwendung großer Textblöcke zu vermeiden und stattdessen individuelle Inhalte zu erstellen. Wenn Inhalte rechtmäßig von anderen verwendet werden, müssen sie mit einem kanonischen Tag versehen werden, das auf das Original verweist.

Wie entstehen duplizierte Inhalte?

Duplizierte Inhalte entstehen häufig, wenn identische Texte oder Medienelemente auf mehreren Websites veröffentlicht werden. Dies kann auf verschiedene Umstände zurückzuführen sein, wie z. B. die Verwendung identischer Produktbeschreibungen auf verschiedenen E-Commerce-Plattformen oder das Kopieren von Inhalten zwischen verschiedenen Domains, was als Content Duplication bezeichnet wird.

Auch technische Faktoren wie URL-Variationen, die auf dieselbe Seite verweisen – z. B. mit und ohne ‚www‘ oder unterschiedliche URL-Parameter – können zu Duplicate Content führen. Auch die Indizierung von Druckversionen von Webseiten oder das Vorhandensein von Session-IDs in URLs ohne entsprechende Canonical-Tags kann zu Duplicate Content führen.

Google und die Prozentsätze beim Content

Google bewertet Inhalte nach ihrer Einzigartigkeit und Relevanz, wobei oft behauptet wird, dass eine URL als Duplicate Content gilt, wenn sie mehr als 70 Prozent Übereinstimmung mit einem anderen Artikel aufweist. Diese Zahl sollte jedoch im Zusammenhang mit dem Linkaufbau und nicht mit dem Inhalt der Website gesehen werden.

Black-Hat-SEO-Praktiken wie Text-Spinning zielen darauf ab, durch geringfügige Textänderungen unter dieser Schwelle zu bleiben, um die Inhalte indexierbar zu machen und Backlinks zu generieren.

Entscheidend ist jedoch, dass die Inhalte einer Website, abgesehen von notwendigen Ausnahmen wie Zitaten, originell und einzigartig sind. Die Algorithmen von Google sind darauf ausgerichtet, qualitativ hochwertigen Content zu erkennen und zu belohnen, während sich offensichtlicher Duplicate Content negativ auf die Sichtbarkeit und das Ranking der betroffenen URLs auswirken kann.

Auswirkung von doppelten Inhalten auf die Nutzererfahrung

Die Nutzererfahrung (User Experience, UX) ist ein weiterer wichtiger Aspekt, der durch doppelte Inhalte beeinträchtigt werden kann. Wenn Besucher auf mehrfach vorhandenen Content stoßen, kann dies zu Verwirrung führen und das Vertrauen in die Website untergraben. Eine klare und eindeutige Präsentation der Inhalte ist daher unerlässlich, um die Zufriedenheit der Nutzer zu gewährleisten und sie dazu zu bewegen, länger auf der Website zu verweilen und mit ihr zu interagieren.

Suchmaschinen wie Google erkennen diese Interaktionen und belohnen Seiten mit einer guten Nutzererfahrung mit einem besseren Ranking in den Suchresultaten. Duplicate Content hingegen kann die Absprungrate erhöhen und die Bindung der Nutzer an die Seite schwächen, was letztlich die Sichtbarkeit der Website in den Suchergebnissen beeinträchtigen kann.

Die häufigsten Ursachen von Double Content

Die häufigsten Ursachen für Duplicate Content sind häufig technische Fehlkonfigurationen und redaktionelle Überschneidungen. Zu den technischen Ursachen zählen unter anderem URL-Variationen, die durch Session-IDs, Tracking-Parameter oder unterschiedliche Protokolle (HTTP und HTTPS) erzeugt werden.

Redaktionell kann Duplicate Content durch das Kopieren von Herstellerbeschreibungen, das mehrfache Publizieren von Inhalten auf verschiedenen Seiten oder das Anbieten identischer Inhalte in verschiedenen Formaten entstehen.